Selbstfahrende Autos versprechen mehr Sicherheit im Straßenverkehr. Die Sensoren und Kameras im Fahrzeug beobachten die Umgebung präziser als ein Mensch es vermag und vermeiden so kritische Situationen. In der Konsequenz gibt es weniger Unfälle, vor allem die Zahl der Verkehrstoten geht drastisch zurück, sobald autonome Autos die Straßen beherrschen. Soweit die Theorie.

Es ist jedoch sowohl der Autoindustrie als auch den größten Verfechtern des technologischen Fortschrittes klar, dass sich in einem komplexen System wie dem Straßenverkehr gefährliche Situationen nicht komplett ausschließen lassen. Ein Hirsch auf der Landstraße, ein Radfahrer, der sich nicht an die Verkehrsregeln hält oder ein Kind, welches sich von der Hand der Mutter losreißt – auch ein selbstfahrendes Auto wird früher oder später mit einem unvorhergesehenen Ereignis konfrontiert.

Viele Fragen offen

Ethische Fragen beschäftigen seit den ersten selbstfahrenden Prototypen Ingenieure und Philosophen. Ist es moralisch, einen Menschen zu opfern, um anderen das Leben zu retten? Muss man vom Passagier erwarten, sich vom System gegen eine Wand fahren zu lassen, um nicht in eine Gruppe Kinder zu fahren? Gelten für eine Gruppe von Senioren die gleichen Maßstäbe wie für die Kinder?

Hinter diesen Fragen steht der grundsätzliche Gegensatz zwischen der Befolgung allgemeiner moralischer Werte („Deontologie“) und einer rationalen Haltung, die alle Konsequenzen einer Handlung nach dem Maßstab des optimalen Nutzens bewertet („Utilitarismus“).

Bisher gibt es kaum Licht im Dunkel der drängenden ethischen Anliegen. Experten warnen, dass autonomen Fahrzeugen der Durchbruch versagt bleibt, solange die moralischen Grundsätze der Algorithmen ungeklärt sind. Der Handlungsbedarf ist erkannt, so wird auch die Bundesregierung eine Kommission einsetzen, um die Voraussetzungen zur Weiterentwicklung und Zulassung selbstfahrender Autos zu schaffen.

Potentielle Nutzer im Dilemma

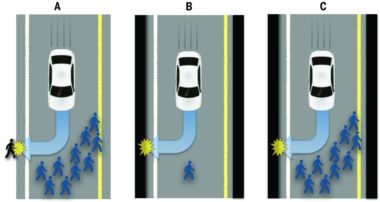

Einen interessanten Beitrag zur Diskussion liefert nun eine auf „Science“ veröffentlichte Kurzversion einer Studie verschiedener US-Universitäten. In der Online-Befragung wurden knapp 2.000 Probanden verschiedene Szenarien vorgelegt, in denen sie gefährliche Situationen entscheiden mussten.

Unter der Überschrift „The social dilemma of autonomous vehicles“ fassen die Forscher die Befunde zusammen. Eine der wesentlichen Erkenntnisse zeigt einen Widerspruch unter den potentiellen Nutzern selbstfahrender Autos auf. So finden es etwa die meisten Studienteilnehmer richtig, dass die Software des selbstfahrenden Autos den Fahrer opfert, um 10 andere Menschen zu schützen. Sitzen sie selbst jedoch im Wagen, erwarten sie von der Software, dass das eigene Leben geschützt wird. Auch würden sie kein Auto kaufen, welches das eigene Leben in Gefahr bringt.

Ein weiterer Befund: Die Teilnehmer wünschen keine regulierenden Eingriffe der US-Regierung in das Thema. Insbesondere wenn der Gesetzgeber Vorgaben macht, dass sich die Software in einer kritischen Situation für die höhere Anzahl von Leben entscheidet, würden die Studienteilnehmer vom Kauf eines selbstfahrenden Autos absehen.

Die unterschiedlichen moralischen Vorstellungen auf einen Nenner zu bringen, dürfte eine der größten Herausforderungen sein, wenn es um selbstfahrende Autos geht. Eine Menge offener Fragen bleiben, man darf gespannt sein!